ÉTICA, SALUD e IA

– Un robot no debe dañar a un ser humano o, por su inacción, dejar que un ser humano sufra daño.

– Un robot debe obedecer las órdenes que le son dadas por un ser humano, excepto cuando estas órdenes se oponen a la primera Ley.

– Un robot debe proteger su propia existencia, hasta donde esta protección no entre en conflicto con la primera o segunda Ley.

Manual de robótica, 56.ª edición, año 2058.

Ya en los 50, Isaac Asimov mostraba preocupación por decisiones morales que pudieran tomar los robots, en varias de sus novelas. Recordando el libro “Yo Robot”, en la página anterior a la introducción, enuncia sus tres famosas leyes de la robótica, escritas previamente.

En la actualidad, donde la tecnología tiene un uso creciente y cotidiano, hay que tener en cuenta que su utilización puede brindar excelentes beneficios, pero también puede causar grandes perjuicios. Debería analizarse el impacto de la tecnología desde varios puntos de vista como ser el humano, el social y el de la naturaleza.

Ética

La Ética ha sido tema de discusión e importancia desde tiempos remotos. Todo ser humano tiene moral, siempre que sea libre de actuar. La Moral se entiende como las reglas o hábitos a seguir para comportarse de manera adecuada. La Ética estudia el comportamiento humano y da fundamentos a la Moral. La moral responde al “qué debo hacer”, la ética responde al “porqué”.

Se tienen indicios que en la Prehistoria ya se utilizaban reglas morales, más relacionadas con cuestiones de supervivencia. En la época de los primeros grandes reinos (asirios, egipcios, etc) la moral tenía más que ver con lo que los dioses ordenaban (ej. Los diez mandamientos) y con lo que a los gobernantes les sirviera (faraones, reyes, etc).

En la antigua Grecia, que también tenía su conjunto de dioses que tenían mucho de humanos, la ética y la moral fueron “racionalizadas” por filósofos y tomaron distancia de la religión y los gobernantes. Sócrates relacionaba a la virtud con el conocimiento “hagamos a los hombres sabios y serán buenos”. Aristóteles por su parte decía que la ética era “la vida buena”. Los griegos pensaban que la felicidad solo se alcanzaba si se tenía una vida virtuosa.

Y es en dicho contexto donde Hipócrates escribió el “Juramento Hipocrático” (hace 25 siglos), uno de sus varios aportes a la medicina.

A continuación, escribo algunos mandatos del juramento:

- Poner todo el empeño e inteligencia en el ejercicio del trabajo.

- Evitar mal e injusticias.

- Ejercer la profesión con inocencia y pureza.

- Hacer el bien en la casa de los enfermos.

- Enseñar medicina.

- Guardar secreto de lo que ve o escucha.

Dicho juramento ha sido utilizado en variadas regiones del planeta desde que fue escrito. Es interesante notar que ya en esa época, se atendía el tema de la confidencialidad de los datos sensibles (guardar secreto de lo que se ve o escucha).

Recién en la Declaración de Ginebra en 1948 la Asociación Médica Mundial (AMM) actualiza dicho juramento y en 2017 la vuelven a “aggionar” (ver aquí).

En el siglo XIX surge el término Deontología como una nueva forma de llamar a la ética. Sin embargo, con el transcurrir del tiempo se resignificó como la ética aplicada a la profesión. Actualmente se considera a la Deontología como la rama de la ética que trata los deberes que rigen actividades profesionales y deberes relacionados con el ejercicio de una profesión. Todas las profesiones u oficios pueden contar con su propia deontología que indique cuál es el deber de cada individuo.

´Responsibility gap´de la Inteligencia Artificial

Retomando lo que había mencionado anteriormente, las aplicaciones informáticas tienen una utilización de vital importancia en múltiples áreas de la sociedad. Ello hace que los profesionales informáticos tengamos grandes posibilidades de hacer “cosas buenas” o causar daño, permitir o influir en otros para que hagan el bien o para que causen daño, sin si quiera ser conscientes de ello. Tomando en cuenta, además, que las aplicaciones de la inteligencia artificial no son solo artefactos de software que realizan ciertas tareas, sino que además aprenden, con la posibilidad de “enseñarse a sí mismas” basadas en la experiencia y ejecutar en base a esos nuevos conocimientos, se genera el riesgo que “escapen” del control de sus propios creadores.

David Gunkel, filósofo de robótica y ética de la Northern Illinois University expresó: ´We’re now at a point where we have AI that are not directly programmed,´ manifestó Gunkel. ´They develop their own decision patterns.´ ´Who is able to answer for something going right or wrong?´

A este dilema Gunkel le llama ´responsibility gap´ de la inteligencia artificial.

De este hecho, se genera el dilema a quién hacer responsable por acciones que tomen ciertas aplicaciones de inteligencia artificial. A modo de ejemplo, podemos citar el problema generado con Microsoft’s Tay AI, un chatbot lanzado al mercado en 2016. Fue diseñado para interactuar con personas en medios sociales y se “entrenaba” (aprendía) con los post y respuestas de los participantes. Pero sucedió que muchos participantes comenzaron a alimentar la red social con contenidos racistas, machistas y otros no deseados. Tay se convirtió como consecuencia, en un chatbot racista y machista, debiendo ser desactivado (ver más aquí).

Debido al acelerado desarrollo de la inteligencia artificial y la robótica de los últimos años, se hace cada vez más necesario definir nuevas normas éticas relativas a la industria del software que constituyan marco de referencia, con el objetivo de preservar los derechos y libertades de los seres humanos, sin frenar el desarrollo tecnológico. Surgen preguntas como ¿es posible que una máquina pueda tomar una decisión moral? ¿no es la ética una cualidad esencialmente humana?

Generando normas morales relacionadas a IA

Se están realizando esmerados esfuerzos para enfrentar este dilema, tal es el caso de la Unión Europea que ha desarrollado un conjunto de siete normas éticas que deberían aplicar las empresas a sus desarrollos de inteligencia artificial.

- Supervisión humana: los sistemas de inteligencia artificial deben permitir sociedades equitativas apoyando la acción humana y los derechos fundamentales y no disminuir, limitar o desviar la autonomía humana.

- Robustez y seguridad: la inteligencia artificial confiable requiere que los algoritmos sean lo suficientemente seguros y lo suficientemente sólidos como para enfrentar errores o inconsistencias durante todas las fases del ciclo de vida de los sistemas de inteligencia artificial.

- Privacidad y control de los datos: los ciudadanos deben tener un control total sobre sus propios datos. Los datos que los conciernen no se utilizarán para perjudicarlos ni discriminarlos.

- Transparencia: se debe garantizar la trazabilidad de los sistemas de IA.

- Diversidad, no discriminación y equidad: los sistemas de AI deben considerar toda la gama de habilidades y requisitos humanos y garantizar la accesibilidad.

- Bienestar social y ambiental: los sistemas de inteligencia artificial deben utilizarse para mejorar el cambio social positivo, mejorar la sostenibilidad y la responsabilidad ecológica.

- Responsabilidad: deben establecerse mecanismos para garantizar la responsabilidad y la rendición de cuentas de los sistemas de AI y sus resultados.

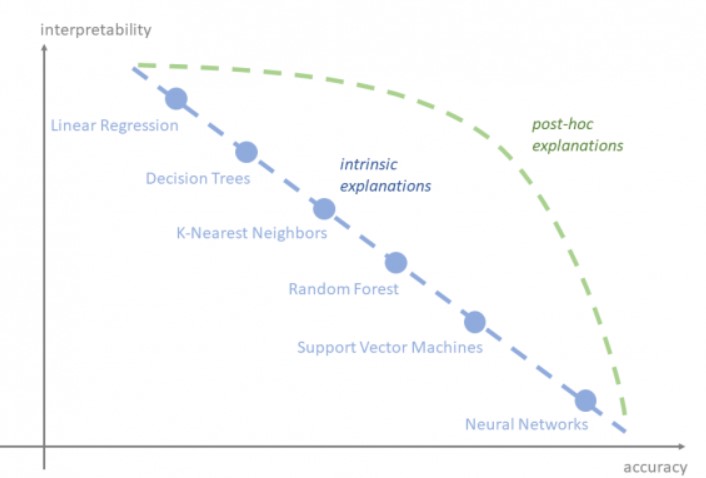

Para viabilizar un modelo, particularmente en salud, un aspecto crítico es lograr su explicabilidad (por qué) e interpretabilidad o trazabilidad (cómo), para entender el camino que lleva a una conclusión basada en aprendizaje automático. Es así que hoy se habla del Derecho a la Explicación, en términos de GDPR.

Esta gráfica muestra diversas técnicas de inteligencia artificial, en relación con la interpretabilidad y la precisión de las predicciones.

Escuchando una entrevista que dio a fm Del Sol el especialista uruguayo en IA Pablo Sprechmann, contaba que la compañía DeepMind para la que él trabaja, define en sus estatutos el no trabajar para proyectos militares. Me pareció un ejemplo interesante de una iniciativa privada respecto a IA & Etica.

Normas y leyes para gestión de datos de salud

A continuación, menciono otros ejemplos, pero orientados hacia la gestión de datos.

En el 2016 se escribió en Taipei la Declaración de la AMM (Asociación Médicos Mundial) sobre las Consideraciones Éticas de las Bases de Datos de Salud y los Biobancos (ver aquí).

En nuestro país, la implantación de la Histórica Clínica Electrónica Nacional (HCEN) se desarrolló acompañada de leyes como las siguientes:

- Ley 18.331 «Ley de protección de datos personales» aprobada en el 2008. Protege datos «sensibles» de las personas (en Europa utilizan el reglamento GDRP)

- Ley 18.335: regula los derechos y obligaciones de los pacientes y

usuarios de los servicios de salud con respecto a los trabajadores de la salud y a los servicios de atención de la salud. Incluye aspectos relativos a la utilización de la HCE (Historia Clínica Electrónica) y a la HCEN.

En USA se utiliza la normativa HIPPA (Health Insurance Portability and Accountability Ac) que regula entre otros aspectos la confidencialidad de los datos que tienen que ver con la Salud.

La realidad es cambiante

Ya pregonaba Herácilto en el S XI AC, el cambio constante en el que se encuentra sumido el mundo y por tanto los seres humanos. Eso sucedió también con los personajes de Asimov. Las 3 leyes de la robótica que formuló inicialmente y utilizó en varias de sus novelas, representaban el código moral que debían respetar los robots. Pero, en el devenir de sus novelas, parecieron no ser suficientes para que el invento “dominara” al inventor…

Y es entonces que la «ley cero de la robótica» aparece por primera vez en la novela de Isaac Asimov “Robots e Imperio” (1985): Un robot no hará daño a la Humanidad o, por inacción, permitir que la Humanidad sufra daño.

Consultora en plataformas de negocios

PD: Agradezco a Fernando López por darle una leída previa cuando el blog era aún un borrador y darme alguna sugerencia; y a Edgardo Noya por su expertise en lo relativo a la bibliografía de Asimov a quien pude consultarle al respecto.