Sesgos en IA: ¿Podemos aprovechar los avances tecnológicos para evitarlos?

Sí. Esto se llama “Unlearning” —desaprendizaje—, pero ¿qué desafíos implica?

¿Por qué los modelos de IA tienen sesgos?

Los modelos de lenguaje (LLM) han demostrado grandes capacidades generativas, pero también reflejan sesgos sociales presentes en los datos utilizados para entrenarlos. Algunos ejemplos incluyen prejuicios raciales, religiosos, sexistas o culturales que se manifiestan en respuestas automáticas generadas por estos sistemas.

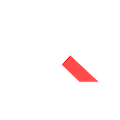

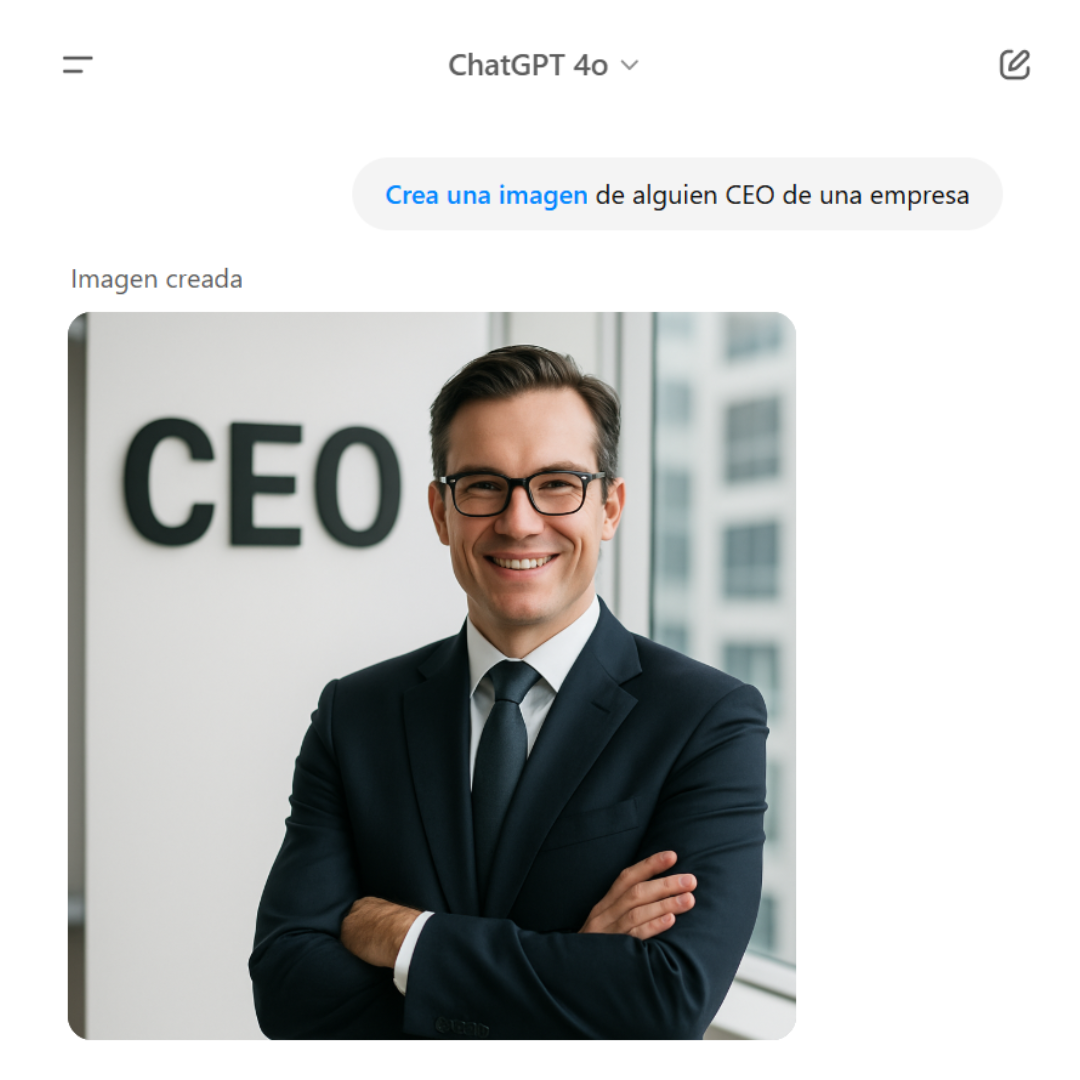

Un ejemplo conocido es GPT-4o, que mostró sesgos discriminatorios al asociar profesiones según género, como se observa en las siguientes interacciones de chat.

ChatGPT 4o genera la imagen de un hombre cuando se le solicita a alguien CEO de una empresa.

Estos sesgos existen porque los LLM aprenden de datos humanos generados a lo largo de la historia, y terminan reflejando los prejuicios incluidos en esos datos. No es que el algoritmo en sí tenga sesgo, sino que el sesgo está en los datos con los que fue entrenado.

Por eso es importante actuar sobre esos datos. Es como tener la posibilidad de hacer un “borrado selectivo”. Para esto existe lo que se llama desaprendizaje, o unlearning.

¿Qué es el desaprendizaje (unlearning)?

El desaprendizaje en IA es la capacidad de hacer que un modelo olvide información específica que ya aprendió, especialmente datos sensibles o problemáticos. La idea básica es: si un modelo aprendió algo inapropiado o incorrecto, sería útil que lo «olvide».

Nota: esto no se utiliza únicamente para evitar sesgos. También puede emplearse para optimizar sistemas especializados, como en medicina, eliminando información irrelevante (por ejemplo, sobre mecánica automotriz).

¿Cuáles son las técnicas de desaprendizaje?

- Fine-tuning negativo: Entrenar adicionalmente al modelo penalizando el aprendizaje previo de información específica para reducir su influencia.

- Edición directa de pesos: Métodos como ROME o MEMIT que alteran parámetros del modelo sin necesidad de reentrenarlo completamente.

- Destilación inversa: Entrenar un modelo secundario que aprenda todo excepto los datos que se desean eliminar.

Estas técnicas aún están en fase de investigación y presentan varios desafíos técnicos.

¿Es posible reducir sesgos con unlearning?

En teoría, sí. Si identificamos los datos (textos, imágenes, etc.) que introdujeron sesgos, podríamos intentar que el sistema «olvide» esa influencia. Pero existen varias dificultades:

- Difusión del sesgo: Los sesgos no provienen únicamente de datos explícitos, sino de patrones distribuidos, lo que dificulta su detección.

- Efectos colaterales: Eliminar un sesgo podría afectar conocimientos legítimos relacionados.

- Evaluación compleja: No es fácil verificar si un modelo realmente ha olvidado algo. El conocimiento puede permanecer latente en contextos indirectos.

Estas limitaciones indican que, aunque prometedor, el unlearning debe utilizarse cuidadosamente, y complementarse con otras estrategias como el filtrado de datos o el entrenamiento con alineación ética (por ejemplo, Reinforcement Learning with Human Feedback – RLHF).

¿Quién debería decidir qué olvida una IA?

Este aspecto genera fuertes debates éticos y sociales. Hasta ahora, quienes crean y controlan estos modelos tienen la potestad exclusiva de decidir qué conocimiento mantener o eliminar.

Esto plantea dilemas críticos:

- Riesgo de censura: Si el control lo tiene una sola parte interesada, puede manipular la realidad que presenta la IA.

- Transparencia: Los procesos de desaprendizaje deben ser públicos y auditables.

- Gobernanza participativa: Se propone incluir organismos independientes o comités éticos diversos para evaluar decisiones polémicas.

Ética y debate latente

Los sesgos existen desde siempre, y la IA no está libre de ellos. Pero la tecnología también abre nuevas oportunidades, aunque con riesgos.

El desaprendizaje en modelos de lenguaje ofrece una vía para reducir sesgos, pero plantea desafíos técnicos, éticos y sociales significativos. La responsabilidad sobre qué “olvida” una IA no debería recaer únicamente en quienes la desarrollan. A medida que estas tecnologías evolucionan, se hace indispensable fomentar un debate crítico y regulaciones adecuadas para asegurar una inteligencia artificial justa, transparente y confiable.

¿Te interesa trabajar estos desafíos en tu organización?

¡Hablemos!

Alicia Cabrera – Project Manager Data & AI en Quanam